SIFT图像拼接:让照片无缝连接的魔法

想把多张照片拼成一张全景图?想让分散的图像片段组合成完整画面?SIFT算法就是实现这一切的"图像胶水"!

什么是图像拼接?—— 照片的"拼图游戏"

想象一下,你站在山顶,眼前是壮丽的全景,但手机相机的视野有限,无法一次拍全。这时候,你可以拍几张重叠的照片,然后用图像拼接技术把它们合成为一张完整的全景图。

图像拼接就像是玩拼图游戏:我们需要找到不同照片之间的重叠部分,然后把它们"粘"在一起。但与拼图不同的是,图像拼接是自动完成的,而SIFT算法就是这个过程中的"眼睛"和"胶水"。

🤔 小思考:为什么普通拍照无法替代图像拼接?因为即使是广角镜头,也有视野限制。而图像拼接可以突破这个限制,创造出比单张照片大得多的视角,甚至是360度全景!

图像拼接的关键在于找到不同图像之间的对应关系。这就像是在两张照片中找到相同的"地标",然后根据这些地标的位置来确定照片应该如何拼接。而SIFT算法正是寻找这些"地标"的高手!

SIFT算法:图像拼接的"智能胶水"

SIFT的全称是"尺度不变特征变换"(Scale-Invariant Feature Transform)。它就像是给图像"贴标签",无论图像怎么缩放、旋转,都能认出这些标签。

SIFT算法主要分为四个步骤:

尺度空间极值检测

就像用不同倍数的放大镜看图片,找到那些在各种尺度下都很明显的点(特征点)。这些点通常是图像中的角点、边缘或斑点。

关键点定位

对找到的特征点进行精确定位,去除那些低对比度和边缘响应的点,只保留最稳定的特征点。

方向分配

给每个特征点分配一个或多个方向,使特征点具有旋转不变性。就像给每个点加上一个"指南针",无论图像怎么旋转,都能认出它。

特征描述符生成

围绕每个特征点,提取其周围区域的梯度信息,生成一个128维的特征向量。这个向量就像是特征点的"身份证",可以用来识别不同图像中的相同点。

有了这些"身份证",我们就可以在不同的图像中找到相同的特征点,然后根据这些点的对应关系,计算出图像之间的变换关系,最终将多张图像拼接成一张完整的全景图。

图像拼接的步骤:从单张到全景的旅程

了解了SIFT算法的原理,我们来详细看看它是如何应用于图像拼接的:

读取输入图像

首先,我们需要读取两张待拼接的图像。这两张图像应该有一定的重叠区域(通常20%-30%),这样算法才能找到足够的对应点。

输入图像1

输入图像2(与图像1有重叠)

检测SIFT特征点

使用SIFT算法在两张图像中分别检测特征点并计算描述符。这些特征点是图像中最具辨识度的部分,如角点、边缘等。

# 初始化SIFT检测器

sift = cv2.SIFT_create()

# 检测SIFT特征点和计算描述符

kp1, des1 = sift.detectAndCompute(image1, None)

kp2, des2 = sift.detectAndCompute(image2, None)匹配特征点

使用FLANN匹配器在两张图像之间匹配相同的SIFT特征点。FLANN(快速最近邻搜索库)能够高效地在大量特征点中找到最佳匹配。

# 使用FLANN匹配器匹配特征点

FLANN_INDEX_KDTREE = 1

index_params = dict(algorithm=FLANN_INDEX_KDTREE, trees=5)

search_params = dict(checks=50)

flann = cv2.FlannBasedMatcher(index_params, search_params)

matches = flann.knnMatch(des1, des2, k=2)筛选优质匹配点

使用Lowe的比率测试筛选出优质的匹配点。这个测试可以帮助我们去除那些可能导致错误拼接的模糊匹配。

# 筛选优质匹配点(根据Lowe的比率测试)

good_matches = []

for m, n in matches:

if m.distance < 0.7 * n.distance:

good_matches.append(m)

print(f'找到 {len(good_matches)} 个优质匹配点')

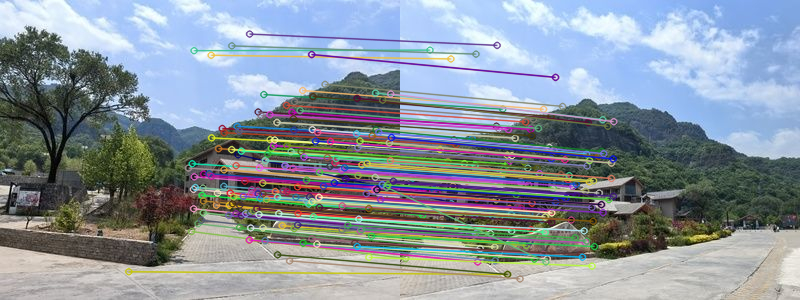

特征点匹配结果(红线连接匹配点)

计算单应性矩阵

根据匹配的特征点,计算出图像之间的单应性矩阵。这个矩阵描述了图像2如何变换才能与图像1对齐。

# 获取匹配点的坐标

points1 = np.float32([kp1[m.queryIdx].pt for m in good_matches]).reshape(-1, 1, 2)

points2 = np.float32([kp2[m.trainIdx].pt for m in good_matches]).reshape(-1, 1, 2)

# 计算单应性矩阵(homography matrix)

H, mask = cv2.findHomography(points2, points1, cv2.RANSAC, 5.0)RANSAC算法:剔除异常值的魔法

在计算单应性矩阵时,我们使用了RANSAC算法(Random Sample Consensus,随机采样一致)。这是一个非常聪明的算法,可以帮助我们从包含噪声的数据中找到正确的模型参数。更多信息可以参考Wikipedia上的详细介绍。

图1:包含噪声的原始输入点

图2:RANSAC算法拟合的最优直线

RANSAC算法原理:从数据中随机采样,找到最适合大多数点的模型

RANSAC算法的工作原理很像"少数服从多数":

- 随机选择一小部分匹配点(通常是4个)计算单应性矩阵

- 用这个矩阵测试所有其他匹配点,统计有多少点符合这个模型(内点)

- 重复以上步骤多次,选择内点最多的模型作为最终结果

在OpenCV中,我们通过cv2.RANSAC参数启用RANSAC算法,后面的5.0表示允许的最大重投影误差(以像素为单位)。

RANSAC算法就像是一个"打假专家",能够从一大堆匹配点中识别出真正有效的匹配(内点),而忽略那些错误的匹配(外点)。这对于提高图像拼接的准确性至关重要!

变换与拼接图像

使用单应性矩阵变换图像2,然后将图像1放置到变换后的图像上,实现初步拼接。

# 使用单应性矩阵变换图像2

height, width = image1.shape[:2]

stitched_width = width + image2.shape[1]

stitched_height = max(height, image2.shape[0])

stitched_image = cv2.warpPerspective(image2, H, (stitched_width, stitched_height))

# 将图像1放置到变换后的图像上

stitched_image[0:height, 0:width] = image1裁剪黑边与优化

拼接后的图像通常会有黑边,我们需要裁剪这些黑边以获得更美观的结果。

# 优化:裁剪黑边

gray = cv2.cvtColor(stitched_image, cv2.COLOR_BGR2GRAY)

_, thresh = cv2.threshold(gray, 1, 255, cv2.THRESH_BINARY)

contours, _ = cv2.findContours(thresh, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

x, y, w, h = cv2.boundingRect(contours[0])

stitched_image_cropped = stitched_image[y:y+h, x:x+w]高级优化:羽化过渡融合

普通的拼接方法可能会在图像接缝处留下明显的痕迹。羽化过渡融合技术可以让接缝处的过渡更加平滑自然。

✨ 羽化魔法:想象一下,在两张图像的重叠区域,我们逐渐增加一张图像的透明度,同时减少另一张图像的透明度。这样,两张图像就会自然地融合在一起,看不出明显的接缝!

以下是实现羽化过渡融合的代码:

# 高级优化:羽化过渡融合

def feather_blend(image1, image2_transformed, width, height):

# 创建羽化掩码

# 计算重叠区域宽度

overlap_width = image2_transformed.shape[1] - width

if overlap_width <= 0:

return image2_transformed

# 创建线性渐变掩码

mask = np.ones((height, width + overlap_width, 3), dtype=np.float32)

for col in range(width, width + overlap_width):

alpha = (col - width) / overlap_width

mask[:, col, :] = 1 - alpha

# 应用掩码

image2_transformed[0:height, 0:width] = image1 * mask[0:height, 0:width] + \

image2_transformed[0:height, 0:width] * (1 - mask[0:height, 0:width])

return image2_transformed

# 使用羽化融合\stitched_image = feather_blend(image1, stitched_image, width, height)羽化过渡融合的关键是创建一个平滑变化的掩码,然后用这个掩码来加权融合两张图像的重叠区域。这样可以避免接缝处的突变,使拼接结果更加自然。

保存与显示结果

最后,我们保存拼接后的图像并显示结果,欣赏我们的全景图!

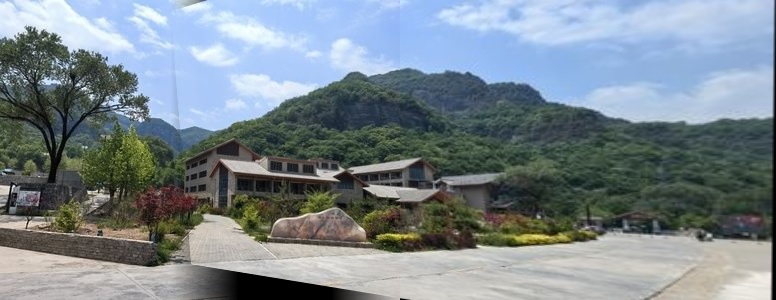

最终拼接结果全景图

最终拼接结果全景图

动手实践:完整Python代码实现

下面是完整的SIFT图像拼接Python代码,包含了羽化过渡融合优化。你可以复制这段代码,保存为sift_stitching.py,然后运行它来体验图像拼接的魔力!

💡 提示:确保你已经安装了必要的库:pip install opencv-python numpy matplotlib

import cv2

import numpy as np

import matplotlib.pyplot as plt

def feather_blend(image1, image2_transformed, width, height):

# 创建羽化掩码

# 计算重叠区域宽度

overlap_width = image2_transformed.shape[1] - width

if overlap_width <= 0:

return image2_transformed

# 创建线性渐变掩码

mask = np.ones((height, width + overlap_width, 3), dtype=np.float32)

for col in range(width, width + overlap_width):

alpha = (col - width) / overlap_width

mask[:, col, :] = 1 - alpha

# 应用掩码

image2_transformed[0:height, 0:width] = image1 * mask[0:height, 0:width] + \

image2_transformed[0:height, 0:width] * (1 - mask[0:height, 0:width])

return image2_transformed

def sift_image_stitching(image_path1, image_path2, output_path='./images/panorama_result.jpg'):

# 读取两张待拼接的图像

print(f'读取图像: {image_path1} 和 {image_path2}')

image1 = cv2.imread(image_path1)

image2 = cv2.imread(image_path2)

if image1 is None or image2 is None:

print('错误:无法读取图像,请检查文件路径')

return None

# 转换为RGB格式(因为OpenCV默认读取的是BGR格式)

image1_rgb = cv2.cvtColor(image1, cv2.COLOR_BGR2RGB)

image2_rgb = cv2.cvtColor(image2, cv2.COLOR_BGR2RGB)

# 初始化SIFT检测器

print('初始化SIFT检测器...')

sift = cv2.SIFT_create()

# 检测SIFT特征点和计算描述符

print('检测SIFT特征点...')

kp1, des1 = sift.detectAndCompute(image1, None)

kp2, des2 = sift.detectAndCompute(image2, None)

# 使用FLANN匹配器匹配特征点

print('匹配特征点...')

FLANN_INDEX_KDTREE = 1

index_params = dict(algorithm=FLANN_INDEX_KDTREE, trees=5)

search_params = dict(checks=50)

flann = cv2.FlannBasedMatcher(index_params, search_params)

matches = flann.knnMatch(des1, des2, k=2)

# 筛选优质匹配点(根据Lowe的比率测试)

good_matches = []

for m, n in matches:

if m.distance < 0.7 * n.distance:

good_matches.append(m)

print(f'找到 {len(good_matches)} 个优质匹配点')

# 绘制匹配点并保存

matched_image = cv2.drawMatches(image1_rgb, kp1, image2_rgb, kp2, good_matches, None, flags=2)

matched_image_path = './images/sift_matching_result.png'

cv2.imwrite(matched_image_path, cv2.cvtColor(matched_image, cv2.COLOR_RGB2BGR))

print(f'匹配点图像已保存至: {matched_image_path}')

# 获取匹配点的坐标

points1 = np.float32([kp1[m.queryIdx].pt for m in good_matches]).reshape(-1, 1, 2)

points2 = np.float32([kp2[m.trainIdx].pt for m in good_matches]).reshape(-1, 1, 2)

# 计算单应性矩阵(homography matrix)使用RANSAC算法

print('计算单应性矩阵...')

H, mask = cv2.findHomography(points2, points1, cv2.RANSAC, 5.0)

# 使用单应性矩阵变换图像2

height, width = image1.shape[:2]

# 计算输出图像的大小,确保能够容纳变换后的图像2和原图像1

stitched_width = width + image2.shape[1]

stitched_height = max(height, image2.shape[0])

print('变换图像...')

stitched_image = cv2.warpPerspective(image2, H, (stitched_width, stitched_height))

# 使用羽化过渡融合

print('应用羽化过渡融合...')

stitched_image = feather_blend(image1, stitched_image, width, height)

# 优化:裁剪黑边

print('裁剪黑边...')

# 寻找非黑色区域的边界

gray = cv2.cvtColor(stitched_image, cv2.COLOR_BGR2GRAY)

_, thresh = cv2.threshold(gray, 1, 255, cv2.THRESH_BINARY)

contours, _ = cv2.findContours(thresh, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

x, y, w, h = cv2.boundingRect(contours[0])

stitched_image_cropped = stitched_image[y:y+h, x:x+w]

# 转换为RGB格式以便显示

stitched_image_rgb = cv2.cvtColor(stitched_image_cropped, cv2.COLOR_BGR2RGB)

# 保存拼接后的图像

cv2.imwrite(output_path, cv2.cvtColor(stitched_image_cropped, cv2.COLOR_RGB2BGR))

print(f'拼接图像已保存至: {output_path}')

# 显示结果

plt.figure(figsize=(18, 10))

plt.subplot(221)

plt.imshow(image1_rgb)

plt.title('图像1')

plt.axis('off')

plt.subplot(222)

plt.imshow(image2_rgb)

plt.title('图像2')

plt.axis('off')

plt.subplot(223)

plt.imshow(matched_image)

plt.title('特征点匹配')

plt.axis('off')

plt.subplot(224)

plt.imshow(stitched_image_rgb)

plt.title('拼接结果')

plt.axis('off')

plt.tight_layout()

plt.show()

return stitched_image_rgb

if __name__ == '__main__':

# 输入图像路径

image_path1 = './images/image_stitching_1.jpg'

image_path2 = './images/image_stitching_2.jpg'

# 执行图像拼接

print('开始图像拼接...')

result = sift_image_stitching(image_path1, image_path2)

if result is not None:

print('图像拼接完成!')

else:

print('图像拼接失败。')🔍 小观察:运行代码时,注意观察控制台输出的信息。它会告诉你代码执行到了哪一步,找到了多少个优质匹配点,以及图像保存的路径。这些信息可以帮助你了解代码的执行状态,以及排查可能出现的问题。

SIFT图像拼接的应用:不止是全景图

图像拼接技术的应用远不止于制作全景照片。它就像一把"瑞士军刀",在很多领域都能发挥重要作用:

全景摄影

这是最常见的应用。无论是风景摄影、房地产展示还是虚拟旅游,全景图都能提供更沉浸的视觉体验。

地图制作

卫星和无人机拍摄的图像通过拼接技术,可以制作出高精度的地图。谷歌地图和百度地图的很多卫星图像都是通过这种方式生成的。

医学影像

在医学领域,图像拼接技术可以将多张断层扫描图像拼接成完整的3D模型,帮助医生更全面地了解患者的病情。

虚拟现实(VR)

VR环境的创建 often 需要大量的全景图像。通过图像拼接技术,可以将真实世界的场景转化为VR环境,让用户获得身临其境的体验。

文物保护

对于大型文物,无法用一张照片完整记录。通过图像拼接技术,可以将多张细节照片拼接成完整的文物图像,便于数字化保存和研究。

自动驾驶

自动驾驶车辆通常配备多个摄像头,图像拼接技术可以将这些摄像头的视野融合成一个完整的360度全景视图,帮助车辆更好地感知周围环境。

🚀 未来展望:随着人工智能和深度学习的发展,图像拼接技术正在向更高精度、更自动化的方向发展。未来,我们可能会看到实时全景视频拼接、超高清全景图生成等更先进的应用!

SIFT算法的故事:从学术研究到产业应用

🧙♂️ 算法的诞生:大卫·洛韦的"十年磨一剑"

SIFT算法是由加拿大计算机科学家大卫·洛韦(David Lowe)在1999年提出的,并在2004年发表了完整的论文。据说,Lowe为了完善这个算法,花了整整十年的时间!

当时,计算机视觉领域面临的一个重大挑战是如何在不同视角、不同光照条件下识别相同的物体。Lowe的SIFT算法通过提取尺度不变的特征点,成功地解决了这个问题,为计算机视觉的发展奠定了重要基础。

⚖️ 专利纠纷:从学术到商业的转变

有趣的是,SIFT算法曾引发过一场轰动一时的专利纠纷。2003年,Lowe所在的英属哥伦比亚大学获得了SIFT算法的专利,并将其授权给了微软公司。

然而,随着开源软件的普及,很多开发者开始在开源项目中使用SIFT算法,这引发了专利侵权的争议。直到2017年,SIFT算法的专利才到期,成为全人类共享knowledge.

现在,SIFT算法已经成为计算机视觉领域的基础算法之一,被广泛应用于图像拼接、物体识别、机器人导航等多个领域。

SIFT图像拼接:连接世界的像素魔法

SIFT算法就像是一位"像素侦探",能够在纷乱的像素世界中找到隐藏的"线索"(特征点),并通过这些线索将不同的图像连接成一个完整的整体。

从大卫·洛韦的学术研究,到如今广泛应用的全景摄影、VR技术,SIFT算法走过了一条从实验室到产业应用的不平凡之路。它不仅展示了计算机视觉的巨大潜力,也让我们看到了数学和算法的魅力。

📝 今日知识点回顾

- 图像拼接是将多张有重叠区域的照片合成为一张更大视角图像的技术

- SIFT算法是图像拼接的核心,它能够提取尺度不变的特征点

- RANSAC算法能够从包含噪声的数据中找到正确的模型参数,提高拼接准确性

- 羽化过渡融合技术可以使图像接缝处的过渡更加平滑自然

-

Python实现:使用OpenCV的

cv2.SIFT_create()函数和FLANN匹配器 - 应用场景:全景摄影、地图制作、医学影像、虚拟现实、文物保护、自动驾驶等

想挑战一下自己吗?试着用今天学到的知识,拍几张有重叠的照片,然后用SIFT算法将它们拼接成一张全景图。或者尝试调整代码中的参数,看看对拼接效果有什么影响。